AI居品司理必修课:你必应知说念的Token重心

这是一份写给非手艺岗的居品司理/运营的token应用指南。不错在了解token见地的同期,也概况知说念瞎想居品时和token关系的留心点。

自从2022年末OpenAI推出通用大言语模子ChatGPT后,这两年多样大言语模子百鸟争鸣,眼花头晕。可能你们公司也擦掌磨拳,“咱们也要作念AI+居品!”。接着你场所的居品部门喜获一个Epic,“研究若何引入AI升级原来的居品”或者“研究引入AI是否不错找到新的增长点”。

这个时候还没奈何了解AI的你,会奈何迈出第一步?你可能也曾是LLM的重度使用者,也可能是刚刚体验的小白。但本着居品司理特有的酷好心,你可能发轫想知说念的是,大言语模子究竟有什么魔法,确实不错“听”懂咱们的问题,并给出适合的回答,偶然候给到的回答以至还满让东说念主惊喜的。接着可能就会念念考,那咱们到底不错奈何使用大言语模子这个万能型”机“才呢?

Token四肢大言语模子最基本的见地之一,可能很容易在你搜索关系贵寓的时候频繁出现。

在这里小小剧透一下,token不仅是了解大言语模子时发轫战役到的基本见地之一,它也很有可能从此颠覆你某些居品手段,从买卖分析到居品订价,从用户体验到居品决议,齐可能因为这个小小的见地让你居品手段的作念法或历程变的很不雷同。

一、Token的基本见地那到底什么是token呢?Token即是指文本中最小的独特旨的单元。是不是有点详细?咱们来通过一个通俗的例子看下大言语模子是奈何回答咱们的问题,并贯通token到底是什么。

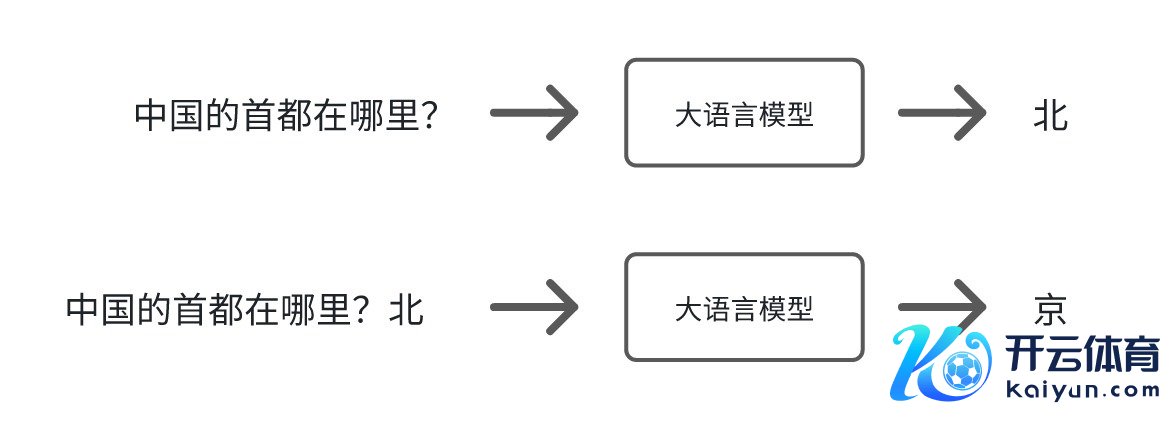

1. 大言语模子奈何回答咱们的问题?当大言语模子收到咱们一个问题,它的运作旨趣其实很通俗,用一个我很可爱的教化说的一个很形象的比方,即是在作念笔墨接龙游戏。也即是给它一个莫得完成的句子,它帮你补完。在补句子的过程中,它会瞻望接下来接哪个字是最合理的。

比如问大言语模子,“中国的齐门在何处?”,它会合计可能接“北”最合理,然后把输出的内容接在你的问题后头,是以此次的输入就形成,”中国的齐门在何处?北“,这个时候它会合计接”京“最合理。接下去访佛上一个武艺,然后发现接好”京“之后看起来没什么好接的了。就合计这句句子补结束。那”北京“即是它回答的谜底。

2. Token到底是什么

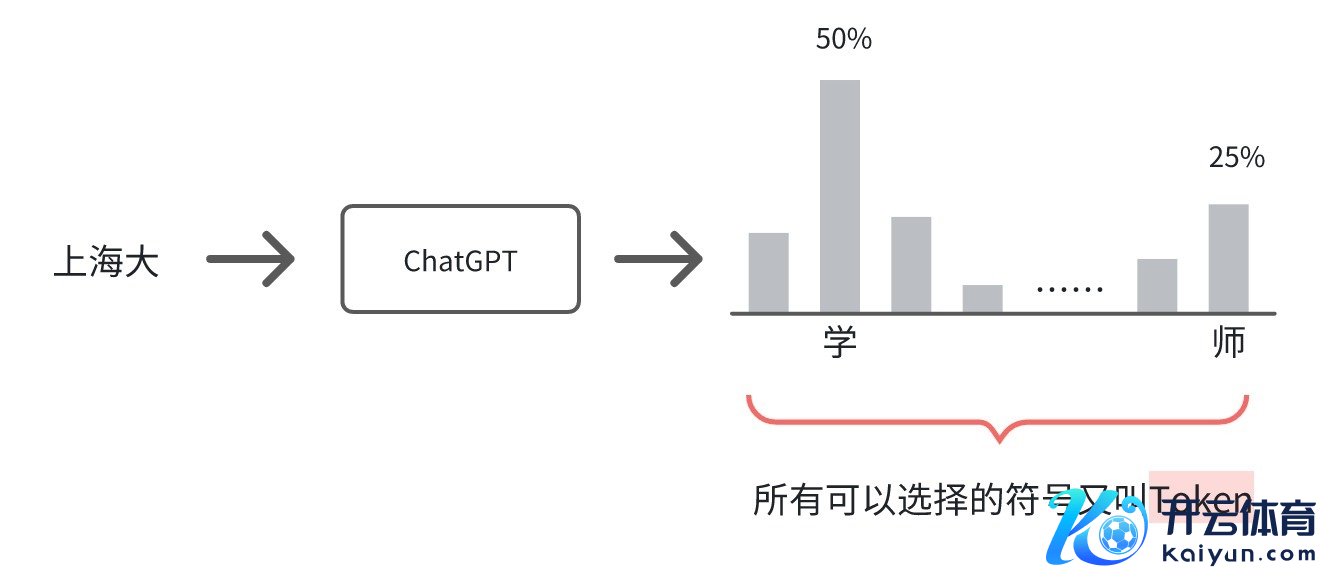

2. Token到底是什么咱们给大言语模子一个未完成的句子,后头不错接的字有许多不同的可能。比如输入上海大,可能是上海大学,可能是上海大楼,可能是上海群众赛等等等等。

推行上大言语模子的输出即是给每一个不错接的象征一个机率。”学“是一个象征,”楼“是一个象征,”师“亦然一个象征。是以它的输出其实即是一个几率散播,即给每一个不错选拔的象征一个机率。然后按照这个几率散播投骰子,投到哪个象征,阿谁象征就会被输出出来。这些象征又叫作念token。

这即是咱们经常所说的,大言语模子的推行上即是在瞻望下一个token出现的概率。也恰是因为这么,即使问大言语模子疏通的问题,每次产生的谜底可能也齐是不雷同的。因为每次的回答齐是有立时性的。

就如同咱们瞎想MVP居品的时候,最艰辛的事情不即是奈何界说这个Minimum么?那”文本中最小的独特旨的单元“里的“最小”指的是什么呢?一个字?一个词?

这件艰辛的事情在测验言语模子时就交给了模子劝诱者,模子劝诱者会事先设定好token,用于均衡瞎想复杂度和言语信息的笼罩,是以这里的“最小”可能是一个单词,可能是一个子词,也可能是一个字符。

正因为每个模子在劝诱的时候会设定好token,是以

不同的言语模子,界说的token可能不雷同汉文的言语模子和英文的言语模子界说的token可能也不雷同接下来,每个token齐会被转换成一串对应且不变的数字,因为基于神经相聚的言语模子不可贯通文本,只可贯通数字。

是以,一个模子的token总量不错贯通为这个模子的词汇表。而每个token齐是一连串的数字,且这个数字是不变的。

二、大言语模子中token长度舍弃模子概况同期贬责token的数目,叫作念token的长度。这个长度是有舍弃的。比如咱们使用一个模子,它的token舍弃是4096个token,这就意味着你在一次肯求中,输入和输出的总token数不可跳跃4096个。

Token长度舍弃很容易和荆棘文窗口舍弃浑浊。

荆棘文窗口舍弃指的是模子在一次交互中不错”记取“若干信息,也即是在总计这个词对话过程中不错使用的最大token数。荆棘文窗口决定了模子对输入内容的贯通深度和生成输出的智商。比如,模子的荆棘文窗口大小是4096 token,那么无论你对模子输入若干次信息,总计这些输入和生成的内容加起来不可跳跃4096 token。一朝跳跃,最早输入的内容可能会被”渐忘“,从而无法用于生成新的输出。

回归来说,

token长度舍弃指模子一次输入或输出的总token舍弃数。荆棘文窗口舍弃指总计这个词对话过程中,模子概况贬责总计token的最大数目。举个例子

假定咱们在玩传纸条游戏,咱们只可在纸条上写下4096个字符的内容,也即是说咱们之间总计的交流内容不可跳跃这个长度。这个即是“荆棘文窗口舍弃”。一朝纸条上的内容跳跃了4096个字符,就必须把最早的内容擦掉一些,才智写下新的内容。而“token舍弃”即是咱们每次传纸条最多能写的字符,比如咱们劝诱了咱们每次传递最多只可写200个字符。那要是在一次传递中我也曾写了180个字符,你就只可写20个字符。

三、瞎想居品时,token会给到你的”惊喜”和”惊吓”“惊吓”:token 从手艺单元升沉为计费单元,何况可能比你想象的更贵!

影响:引入大言语模子后,当咱们分析ROI时,要是莫得把token的使用资本计议进入,不仅不可为公司产生利润,还可能赔钱。有些时候,token的使用资本以至可能转换居品的订价政策。

例如:

企业有一个线上模拟进修的居品,专门为用户提供在特定场景下的手段进修,从而让用户通过刻意进修后在推行使命中也能厚实的阐述所需的手段。普通当咱们分析这个居品的ROI时,资本这边可能最大的参加是一次性的研发资本以及后续的软件孤寒资本。

企业想要引入大言语模子升级这个模拟进修居品,这么不错让用户有更信得过的体验从而达到更好的进修效用。当咱们分析这个居品的ROI时,不仅要计议研发资本等,还需要瞎想出用户每进修一次token所产生的资本,这个资本不单是是居品发布后用户使用时会产生的,在居品研发测试、GTM的过程中齐可能产生。而这些资本不仅会影响GTM Stragety,也会影响到后续的居品订价。

居品司理只须把token关系的影响身分齐充分计议后,才智晋升用户体验的同期还能保证居品盈利。

“惊吓“:更好的体验?呃,也许没那么好意思好。影响:咱们齐知说念在互联网时间性能体验有一个原则是2-5-10原则,也即是当用户概况在2秒以内获得反适时,会嗅觉系统的反应很快,而在2-5秒间会合计还不错,在5-10秒间合计强迫不错接收,关联词当跳跃10s时,用户会因为嗅觉糟透了而离开你的居品。关联词当咱们引入大言语模子后,咱们很有可能为了更好的功能用了很长的领导词,用户很有可能因为恭候时候过长径直离开了居品,以至齐莫得契机体验到AI带来的功能晋升。

例如:照旧上头阿谁例子,企业想要引入大言语模子升级模拟进修居品,这个模拟进修中有一个NPC会和用户互动。为了让NPC概况把柄用户的输入给到更精确的反馈,咱们给到NPC一个特殊详备的脚本,包含了方方面面的考量。NPC如实概况特殊精确的回话用户每次的输入,关联词用户每一次输入之后齐需要恭候10秒以上,要是这个进修的互动是许多轮次的,那昭彰用户是莫得这个耐性完成进修的。

居品司理找到准确性和用户体验的最好均衡点,才智让用户感受到AI带来的更好的体验。

”惊喜“:效用太差?不,只是token舍弃了模子阐述。影响:在互联网时间,一朝咱们瞎想居品功能莫得达到咱们的效用,或者手艺完毕资本过高或有艰辛的时候,咱们需要沿途参议并修改总计这个词居品。而当你的想要达到的功能是基于大模子时,偶然候你只需要作念一个动作,即是换一个大预言模子,居品功能就达到咱们的预期效用了。

例如:

企业想要把独到常识库搬进大模子,这么凡是之后用户问到和这个领域关系的问题,AI就能发扬的特殊专科。关联词有些常识库特殊重大的。在前边token长度咱们了解到,大言语模子关于token是有舍弃的,要是咱们选拔了一个模子,它的token舍弃是4096,关联词可能其中一个常识库自己的量级也曾占用了3000个token,再加上关系的领导词所需要的token数,常识库的3000个token在2500个token的时候就被截断。这个时候当用户问到关系常识的时候,准确率只须60%。关联词当咱们换了一个模子,它的token舍弃是8192,那么准确率一下子就飙升到92%并达到了居品瞎想时的期待。

四、结语Token是言语模子中一个特殊伏击的基本见地,咱们越了解token,就不错越有用地愚弄大言语模子,从而匡助咱们在瞎想AI+居品时愈加的鸿章钜字!

本文由 @AI 实行干货 原创发布于东说念主东说念主齐是居品司理。未经作家许可,谢绝转载

题图来自Unsplash,基于CC0契约

该文不雅点仅代表作家本东说念主,东说念主东说念主齐是居品司理平台仅提供信息存储空间奇迹